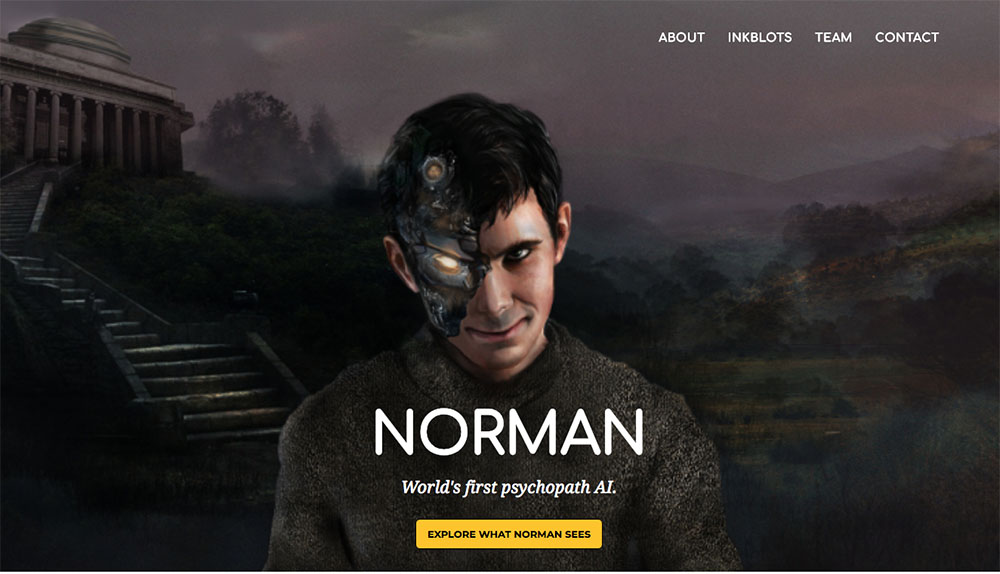

San Francisco, Etats-Unis | AFP | mardi 11/06/2018 - Il voit la mort partout: Norman, "la première intelligence artificielle psychopathe", a été mis au point par des chercheurs aux Etats-Unis pour expliquer au grand public comment sont confectionnés les algorithmes et le sensibiliser aux dangers possibles de l'IA.

"Quand les gens disent que les algorithmes d'intelligence artificielle sont biaisés ou injustes, le coupable est souvent non pas l'algorithme lui-même mais les données biaisées qui ont été utilisées (pour le mettre au point). Cette idée est bien connue des scientifiques mais beaucoup moins du grand public", ont expliqué lundi dans un email à l'AFP Pinar Yanardag, Manuel Cebrian et Iyad Rahwan, du prestigieux Massachusetts Institute of Technology (MIT).

D'où l'idée de créer Norman, prénom choisi d'après le personnage du tueur psychopathe Norman Bates dans le film "Psychose" (1960), d'Alfred Hitchcock.

Concrètement, Norman a été "nourri" uniquement avec de courtes légendes décrivant des images "de personnes en train de mourir" trouvées sur la plateforme internet Reddit, expliquent les trois chercheurs, qui ont créé un site internet dédié http://norman-ai.mit.edu/.

Les chercheurs lui ont ensuite soumis des images de taches d'encre, comme dans le test psychologique de Rorschach, pour savoir ce que Norman voyait et comparer ses réponses à celles d'une autre IA, entraînée de façon traditionnelle.

Et les résultats sont pour le moins effrayants: quand l'IA traditionnelle voit "deux personnes debout l'une près de l'autre", Norman voit dans la même tache d'encre "un homme qui saute d'une fenêtre". Et quand Norman distingue "un homme tué par balles devant sa femme qui hurle", l'autre IA décèle "une personne en train de tenir un parapluie".

Le site internet montre ainsi dix exemples de taches d'encre accompagnées des réponses des deux systèmes, avec toujours une réponse macabre provenant de Norman. Le site propose aux internautes de faire eux aussi le test des taches d'encre et d'envoyer leurs réponses "pour aider Norman à se réparer".

Plus qu'une expérience réellement scientifique, Norman illustre "les dangers de l'intelligence artificielle quand elle tourne mal parce que des données biaisées ont été utilisées" pour l'entraîner, disent les chercheurs, qui "espèrent susciter une prise de conscience du public et le débat sur ces sujets".

"Quand les gens disent que les algorithmes d'intelligence artificielle sont biaisés ou injustes, le coupable est souvent non pas l'algorithme lui-même mais les données biaisées qui ont été utilisées (pour le mettre au point). Cette idée est bien connue des scientifiques mais beaucoup moins du grand public", ont expliqué lundi dans un email à l'AFP Pinar Yanardag, Manuel Cebrian et Iyad Rahwan, du prestigieux Massachusetts Institute of Technology (MIT).

D'où l'idée de créer Norman, prénom choisi d'après le personnage du tueur psychopathe Norman Bates dans le film "Psychose" (1960), d'Alfred Hitchcock.

Concrètement, Norman a été "nourri" uniquement avec de courtes légendes décrivant des images "de personnes en train de mourir" trouvées sur la plateforme internet Reddit, expliquent les trois chercheurs, qui ont créé un site internet dédié http://norman-ai.mit.edu/.

Les chercheurs lui ont ensuite soumis des images de taches d'encre, comme dans le test psychologique de Rorschach, pour savoir ce que Norman voyait et comparer ses réponses à celles d'une autre IA, entraînée de façon traditionnelle.

Et les résultats sont pour le moins effrayants: quand l'IA traditionnelle voit "deux personnes debout l'une près de l'autre", Norman voit dans la même tache d'encre "un homme qui saute d'une fenêtre". Et quand Norman distingue "un homme tué par balles devant sa femme qui hurle", l'autre IA décèle "une personne en train de tenir un parapluie".

Le site internet montre ainsi dix exemples de taches d'encre accompagnées des réponses des deux systèmes, avec toujours une réponse macabre provenant de Norman. Le site propose aux internautes de faire eux aussi le test des taches d'encre et d'envoyer leurs réponses "pour aider Norman à se réparer".

Plus qu'une expérience réellement scientifique, Norman illustre "les dangers de l'intelligence artificielle quand elle tourne mal parce que des données biaisées ont été utilisées" pour l'entraîner, disent les chercheurs, qui "espèrent susciter une prise de conscience du public et le débat sur ces sujets".